Introducción

Los efectos de la digitalización en el mundo académico han fomentado el uso del acceso abierto para los resultados investigativos: una modalidad de publicación que aboga por ofrecer el contenido de las revistas académicas de forma gratuita y sencilla, bien en repositorios, bien a través de las propias revistas (Clarke, 2007); totalmente (green road) o con algún tipo de moratoria (golden road) (Guèdon, 2004; Harnad et al., 2004).

Los stakeholders de las instituciones científicas están interesados en la extensión de esta modalidad. Los editores de revistas académicas españolas perciben que las ventajas del open access sobrepasan ampliamente sus inconvenientes (Segado-Boj, Martín-Quevedo y Prieto-Gutiérrez, 2018a). Los autores también apoyan el acceso abierto y creen que se convertirá en el modelo dominante en los próximos cinco-10 años, especialmente los más jóvenes (Segado-Boj, Martín-Quevedo y Prieto-Gutiérrez, 2018b; Zhu, 2017). Existe evidencia sólida de que los artículos en acceso abierto reciben más citas (Harnad y Brody, 2004; Antelman, 2004; Gargouri et al. 2010; Miguel, Chinchilla-Rodríguez y Moya-Anegón, 2011), algo en lo que editores y autores están interesados.

Por otra parte, las propias universidades tienen motivos para apoyar la difusión de la investigación. La reputación y el prestigio son dos de los activos más importantes en la academia, tanto para los individuos como para las instituciones (Becher, 1989), y esta reputación depende principalmente de dos factores: la productividad (cantidad y calidad de la investigación) y el impacto (citas) (Herman y Nicholas, 2019: 3 (e280102)). Más aún: los rankings de universidades tienen como uno de sus factores principales el número de artículos publicados en revistas científicas de Web of Science y Scopus. Es el caso de Shanghai Ranking, el Ranking QS y el de la Universidad Nacional de Taiwan (NTU). Los medios en España prestan mucha atención a la publicación de estos rankings, por lo que son un factor decisivo en la creación de la identidad de marca de una universidad (González-Riaño, Repiso y Delgado López-Cózar, 2014).

Más allá de la responsabilidad de las universidades, desde gobiernos e instituciones se ha señalado esta creación y transferencia de conocimiento como un objetivo estratégico. La Comisión Europea lo plasma en el programa Horizonte 2020 (European Comission, 2017). Se busca que a partir de 2020 todas las investigaciones financiadas con fondos públicos en Europa estén disponibles de forma gratuita y que los datos de todo el proceso de investigación sean de acceso abierto para su consulta y posible reutilización. Esto es, una ciencia abierta, colaborativa y “hecha con y para la sociedad” (Anglada y Abadal, 2018: 294). Tal coyuntura afecta a las universidades españolas, ya que la mayor parte de la producción científica se financia con fondos públicos.

En este contexto, la difusión de la información académica y científica se convierte en una función primordial para las instituciones, fomentando el acceso abierto (Melero, 2008), activando portales de producción científica (Calderón-Rehecho, 2017), creando unidades bibliométricas (González-Fernández-Villavicencio, 2017), realizando actividades de formación, publicando convocatorias de innovación docente, apostando por la activación de los perfiles únicos de investigadores, publicando su actividad investigadora, etcétera.

Por todo ello, este artículo se propone explorar la relación entre las acciones de apoyo al investigador y difusión del conocimiento científico en universidades y otros centros de educación superior españoles, por un lado, y la posición que ocupan en el SIR (Scimago Institutions Ranking), como reflejo de su éxito al fomentar la producción y reforzar la propia identidad de marca del centro, por el otro. Se trata, por lo tanto, de ofrecer un diagnóstico situacional que colabore con la gestión universitaria, aportando información reductora del riesgo en la toma de decisiones a favor de la visibilidad académica y la reputación institucional.

Objetivos

Para identificar si las instituciones universitarias españolas colaboran activamente con la excelencia de la comunidad investigadora, se plantean los siguientes objetivos:

OB1. Identificar los servicios que los centros de formación superior españoles ofrecen a la comunidad científica en colaboración con la excelencia investigadora desde dos perspectivas complementarias: el acceso a contenidos científicos y el control y medición de resultados.

OB2. Analizar si existe correlación entre la posición de las universidades españolas en el SIR y la oferta de servicios que las universidades analizadas ofrecen a la comunidad científica.

Fuentes y metodología

El fenómeno expansivo de los rankings universitarios y su aplicación como medida de reconocimiento han suscitado no pocas críticas que, en gran medida, se refieren a la percepción de conceptos como calidad o excelencia aplicados a un entorno productivo multidimensional (Pérez-Esparrells y Gómez-Sancho, 2010). Las voces discordantes apuntan, por un lado, a disfunciones metodológicas para evaluar la excelencia de una universidad (dado que no sólo es relevante la selección de variables, sino también el peso específico que se le atribuye a cada una) y, por el otro, a la tendencia a la uniformización de criterios a nivel global, desoyendo las particularidades locales de cada institución (Albornoz y Osorio, 2018), algo que ya se reflejó en los Berlin Principles on Rankings of Higher Education Institutions (Unesco-Cepes, Institute for Higher Education Policy, 2006).

Las diferencias tanto en resultados como en metodología aplicada para realizar los rankings universitarios han derivado en la propuesta de taxonomías para facilitar su análisis crítico. En este sentido, Aguillo (2012) propuso una diferenciación entre rankings que se basan en encuestas de opinión, como el QS o el Times Higher Education, y los basados en bibliometría o cibermetría, esto es, rankings que se centran en análisis cuantitativos de las producciones científicas o de la visibilidad web institucional. En esta segunda categoría se ubicarían las clasificaciones del HEEACT, de Taiwan, o el del CWTS, de la Universidad de Leiden, basados en la base de datos Web of Knowledge (WoK); el ranking de SCImago (SIR), que utiliza la base de datos de Scopus, o el Ranking Web de Universidades, desarrollado por el CSIC y que aporta, como característica distintiva, las citas de Google Académico como referencia (Albornoz y Osorio, 2018; Aguillo, 2012).

En esta ocasión, se ha elegido el SIR porque es un ranking basado en bibliometría y cibermetría, es decir, se apoya en datos exclusivamente cuantitativos; se focaliza en los resultados de la investigación institucional y obvia aspectos que se escapan al fin específico de esta investigación, como la reputación, la docencia o la presencia de premios nobel en los claustros. Se apoya en la base de datos Scopus, uno de los principales repositorios bibliográficos con acceso a resúmenes y referencias de publicaciones revisadas por pares, junto a Web of Science, lo que garantiza su reconocimiento internacional (véanse estudios comparados de Web of Science, Scopus y Google Académico (Martín-Martín et al., 2018; Delgado López-Cózar y Repiso, 2013; López-Illescas, Moya-Anegón y Moed, 2008)); es un ranking que alberga un gran número de universidades españolas y tiene una representación global homogénea (Moya-Anegón et al., 2007), lo que permite realizar un amplio estudio que abarca centros académicos con características heterogéneas.

SIR, desarrollado por SCImago Lab, ordena a las universidades con actividad investigadora mediante un indicador compuesto que combina tres grupos de datos basados en investigación (con 11 campos de análisis y un valor de 50 % en el ranking), innovación (tres campos de análisis y valor de 30 %) e impacto social (tres campos de análisis y valor de 20 %), medido este último por la visibilidad de su web (SCImago Institutions Ranking, 2019). En 2018 se incluyeron en el ranking 5 637 instituciones, de las cuales 3 234 corresponden al sector de la educación superior, 63 de ellas en España.

SIR, como el resto de los rankings de referencia, analiza el aquí denominado output investigador -analogía con la teoría propuesta por Leontief (1986). Esto es, el resultado o reflejo de la actividad de los PDI (personal docente e investigador) vinculados con las instituciones universitarias a favor de la construcción y visibilidad de la ciencia. En esta ocasión, el OB1 busca analizar lo que, siguiendo la misma lógica, se denomina input, es decir, las entradas, herramientas o servicios que reciben los investigadores por parte de las instituciones como apoyo a la producción científica, esto es, se entiende a los inputs como acicates del acceso y difusión del conocimiento, en línea con las premisas que sustentan la defensa de la ciencia de acceso abierto y que, sin duda, colaboran como catalizadores de la excelencia científica. Finalmente (OB2), se busca identificar si existe una correspondencia entre el resultado del ranking basado en outputs (SIR) y el ranking basado en inputs.

La metodología aplicada (OB1) se fundamenta en el estudio de casos múltiples y la técnica del análisis de contenido. La muestra se corresponde con las 63 instituciones referidas en 2018, contando así con los resultados fijos de un año natural. El análisis de contenido se realizó a partir de la información pública de estas organizaciones, principalmente de sus páginas web. Esto es, no se buscaron servicios internos no visibles para la comunidad científica. Sin embargo, sí se consideraron para el análisis todos aquellos servicios publicados en fuentes institucionales, aunque estos exijan identificación para poder acceder. La idea que subyace a esta lógica es la facilidad de acceso y uso por parte del conjunto de la comunidad científica, y no sólo de los miembros de esa organización. Se debe matizar, como limitación metodológica, que pueden existir servicios albergados en intranets cerradas que esta investigación ignora, pero cuya ausencia en la cuantificación se justifica con la idea antes mencionada.

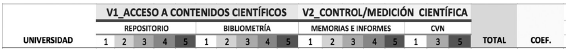

Para garantizar la sistematicidad en la fase de observación, se diseñó la ficha de análisis que muestra la Figura 1

Las variables estudiadas se evaluaron con escalas Likert de cinco puntos, donde el 1 tiene el valor más bajo y el 5 el más alto.

Tabla 1 Variables contempladas en el análisis de contenido

|

Variable 1. Acceso a contenidos científicos 1.1. Repositorios con acceso a contenidos científicos 1. No. 2. Sí, pero con acceso cerrado (personal logueado). 3. Sí, pero con baja visibilidad (acceso a la biblioteca/repositorio desde la home page en un solo click). 4. Sí, buena o alta visibilidad (aparece el enlace en la home page de la web corporativa o en dos clicks, por ejemplo, a través del botón recursos). 5. Sí, buena o alta visibilidad e información adicional (políticas de gestión, estadísticas de uso, etc.). 1.2. Servicios de bibliometría a disposición del usuario 1. No. 2. Sí, pero con acceso cerrado (personal logueado). 3. Sí, enlaces a portales externos (se incluye información de indicadores externos sin tratamiento propio y sin adaptación a las particularidades institucionales). 4. Sí, información e indicadores bibliométricos propios (elaborados por la universidad. Se puede inferir de aquí que disponen de una unidad de bibliometría). 5. Sí, información e indicadores bibliométricos propios con posibilidad de búsqueda avanzada (acotación por gestión, investigación, departamento o PDI). Variable 2. Control y evaluación de la actividad científica e investigadora 2.1 Publicación de memorias e informes de investigación 1. No, sólo publicación de informes generales no relativos a la actividad investigadora. 2. Sí, publicación de memorias o informes relativos a la gestión y producción científica que cumplen alguna de estas condiciones: no periódicos, sin actualizar al menos hasta 2014 (porque muchos proyectos científicos tienen una duración de 4 años y publican sus informes al finalizarlos), fragmentados (por departamentos o grupos de investigación) o de cuyo contenido no hay indicios de acceso cerrado. 3. Sí, publicación de memorias o informes relativos a la gestión y producción científica periódicos y de acceso cerrado. 4. Como el punto 2, pero de acceso abierto. 5. Como el punto 3, pero de acceso abierto. 2.2 Servicios de uniformización del currículo CVN (la gradación en esta variable se reduce a tres posibilidades para adaptarse a las características propias del objeto analizado). 1. No. 3. Sí, opción de exportación del CVN. 5. Sí, opción de exportación e importación del CVN. |

Resultados

Repositorio

El análisis de los repositorios institucionales ha puesto de manifiesto que 100 % de los repositorios y los catálogos dependen de la gestión de las bibliotecas y los centros de documentación institucionales.

De la muestra analizada, 60 instituciones ofrecen un repositorio en acceso abierto para alojar su producción científica. Tan sólo en la Universidad de Navarra el repositorio es de acceso cerrado (necesita identificación), y dos de ellas, Ramon Llull y Católica de Valencia, carecen de repositorio. En 44 universidades se accede al repositorio directamente desde la home page. En otras nueve se accede en dos clicks y en siete el itinerario es más difícil.

Se ha detectado que, de un centro a otro, la interfaz y los servicios que se ofrecen varían enormemente. Se identifican repositorios que recuperan la información en bloque y de forma global, y repositorios que cuentan con varias opciones de búsqueda. Cada vez más centros emplean catálogos tipo Discovery, donde, desde un espacio de búsqueda único, se centralizan todas las bases de datos de la institución, las propias y las contratadas.

Las bibliotecas y vicerrectorados pertinentes deben seguir trabajando para incentivar el autoarchivo del PDI para cumplir los mandatos de acceso abierto recogidos en el artículo 37 de la Ley de la Ciencia, la Tecnología y la Innovación y en el artículo 29.2 del Programa Horizonte 2020.

Bibliometría

Dentro del grupo de instituciones que no presentan ningún indicador de la literatura científica propia, ni en formato textual ni gráfico, se engloban 20 instituciones (31.7 %). Las instituciones cuyo servicio de información bibliométrica está dirigido al personal del centro, exigiendo identificador, son 11 (17.4 %).

Se identificaron siete universidades que muestran públicamente una información científica sin elaborar (11.1 %), que a veces captan gráficos de fuentes externas, como Dialnet y Scopus.

Las instituciones que ofrecen información científica de calidad en acceso abierto son 25, lo que supone casi 40 %. En 15 casos (23.8 % respecto del total) de los 25 disponen de ricas unidades de bibliometría. En este conjunto sobresalen aquellos centros que acceden al portal Recerca (21 instituciones catalanas). Es un portal en abierto donde es posible hacer búsquedas por centro, departamentos, institutos y áreas, proyectos de investigación, grupos de investigación, investigadores, publicaciones y tesis. El resto, 10 instituciones, ofrecen información propia sobre su producción científica.

Varias universidades catalanas, además de Recerca, tienen su propio portal de producción científica: la Politécnica de Cataluña mantiene FUTUR, y la Pompeu Fabra posee PPC. Otras universidades ofrecen acceso a GREC (Gestió de la Recerca), que ofrecen en acceso abierto instituciones como Girona, Rovira i Virgili, Ramon Llull, Abat Oliba y Lleida. En cambio, se mantienen en acceso cerrado la Universidad de Valencia y de las Islas Baleares (Illes Balears). De las seis primeras instituciones del ranking, cinco ofrecen información bibliométrica de calidad.

El amplio abanico de escalas y profundidades de los espacios bibliométricos dificulta los procesos evaluativos. Pocas universidades ofrecen espacios destinados a visibilizar los documentos publicados, su impacto, uso de métricas de datos, grupos o proyectos de investigación. El futuro de los portales de bibliometría pasa por trabajos colaborativos entre instituciones, con la Oficina de Transferencia de Resultados de Investigación (OTRIs), bibliotecas y los vicerrectorados. La puesta en marcha de incipientes proyectos, como los de Granada, Complutense, Carlos III o los integrantes de GREC, hace pensar que las universidades están comenzando a invertir en este campo, que tiene incidencia directa en las propias instituciones, en los investigadores y en las publicaciones; esto es, colabora como catalizador de la visibilidad científica, también impulsada por la popularización del open access (Miguel, Chinchilla-Rodríguez y Moya-Anegón, 2011).

Memorias e informes de investigación

Diecisiete universidades (casi 27 %) se sitúan en el área más baja al no disponer de memorias o informes de investigación, o bien publican memorias globales sin diferenciar la investigación.

Cinco universidades (8 %), Valencia, Pompeu Fabra, Vigo, La Laguna y La Rioja, poseen indicios de publicación de memorias, pero su acceso es cerrado y se limita a usuarios de cada institución.

El resto de organizaciones (41, 65 %) publican memorias de investigación en acceso abierto. Dieciocho universidades (28.5 %) disponen de memorias de investigación sin actualizar o fragmentadas (publicadas por departamentos o institutos). Por ejemplo, la de Islas Baleares ofrece memorias de investigación anuales hasta 2007 y Comillas hasta 2010.

En la parte más alta de la clasificación se sitúan 28 universidades (44.5 %), que publican memorias relativas a la investigación de forma periódica y en acceso abierto. Los resultados han demostrado que 16 universidades (25 %) no ofrecen ni siquiera un leve testimonio relativo a la actividad investigadora. En relación con la variable anterior, la posibilidad de publicar informes puede ir ligada a la puesta en marcha de portales o espacios bibliométricos, ya que a través de ellos se facilita la difusión de los documentos acreditativos de la actividad investigadora.

CVN

La interoperabilidad que ofrece el uso del currículum vitae normalizado (CVN) para participar en convocatorias de ayudas del Plan Estatal y autonómico no se aprovecha en 11 instituciones (17.5 %).

De la muestra analizada, 52 universidades (82.5 %) tienen ya implantado CVN, lo que permite generar, modificar y exportar un currículum normalizado desde las plataformas institucionales. De ellas, sólo 10 (15.8 %) tienen activada la opción de importar el CVN.

Es destacable el empleo de las mismas plataformas por un amplio grupo de instituciones: 10 de las universidades andaluzas ofrecen SICA (Sistema de Información Científica de Andalucía); Universitas XXI - Investigación, desarrollado por la Oficina de Cooperación Universitaria (OCU), es utilizado por siete centros de varias CCAA, y siete instituciones de Cataluña, Valencia e Islas Baleares utilizan el portal GREC (Gestió de la Recerca).

Los beneficios de emplear el CVN son muchos, y la puesta en marcha es sencilla. Por tanto, es un elemento fundamental para llegar a la excelencia investigadora.

A partir de las valoraciones otorgadas a las cuatro dimensiones señaladas (Tabla 3), se compara la posición de los centros analizados en el ranking SIR (output) y el basado en los servicios ofertados a la comunidad científica (input).

Tabla 2 Variación entre la posición de los centros en SIR (output) y el ranking basado en los servicios analizados (input)

| Universidades | Input | Output | Variación |

| Posición en ranking de estrategias de fomento internas | Posición en SIR | ||

| Barcelona | 4 | 1 | -3 |

| Autónoma de Barcelona | 2 | 2 | 0 |

| Autónoma de Madrid | 3 | 3 | 0 |

| Complutense de Madrid | 6 | 4 | -2 |

| Politécnica de Valencia | 13 | 5 | -8 |

| Politécnica de Catalunya | 9 | 6 | -3 |

| Valencia | 47 | 7 | -40 |

| Sevilla | 38 | 8 | -30 |

| País Vasco | 44 | 9 | -35 |

| Pompeu Fabra | 19 | 10 | -9 |

| Granada | 7 | 11 | 4 |

| Politécnica de Madrid | 18 | 12 | -6 |

| Zaragoza | 25 | 13 | -12 |

| Navarra | 16 | 14 | -2 |

| Santiago de Compostela | 37 | 15 | -22 |

| Rovira i Virgili | 24 | 16 | -8 |

| Oviedo | 17 | 17 | 0 |

| Salamanca | 53 | 18 | -35 |

| Carlos III de Madrid | 5 | 19 | 14 |

| Murcia | 21 | 20 | -1 |

| Vigo | 52 | 21 | -31 |

| Málaga | 43 | 22 | -21 |

| Castilla-La Mancha | 20 | 23 | 3 |

| Córdoba | 40 | 24 | -16 |

| Jaume I | 33 | 25 | -8 |

| Girona | 49 | 26 | -23 |

| Alacant | 14 | 27 | 13 |

| Valladolid | 48 | 28 | -20 |

| Alcalá | 10 | 29 | 19 |

| Miguel Hernández | 54 | 30 | -24 |

| Pública de Navarra | 22 | 31 | 9 |

| Cantabria | 28 | 32 | 4 |

| Lleida | 42 | 33 | -9 |

| Palmas de Gran Canaria | 1 | 34 | 33 |

| Cádiz | 11 | 35 | 24 |

| Jaén | 32 | 36 | 4 |

| Pablo de Olavide educación | 36 | 37 | 1 |

| La Laguna | 12 | 38 | 26 |

| Ramon Llull | 46 | 39 | -7 |

| Illes Balears | 31 | 40 | 9 |

| Coruña | 56 | 41 | -15 |

| Extremadura | 29 | 42 | 13 |

| Rey Juan Carlos | 23 | 43 | 20 |

| Almería | 26 | 44 | 18 |

| León | 34 | 45 | 11 |

| Huelva | 30 | 46 | 16 |

| La Rioja | 41 | 47 | 6 |

| Nacional de Educación a Distancia | 35 | 48 | 13 |

| Burgos | 27 | 49 | 22 |

| Politécnica de Cartagena | 58 | 50 | -8 |

| San Pablo CEU | 55 | 51 | -4 |

| Internacional de Catalunya | 50 | 52 | 2 |

| Oberta de Catalunya | 8 | 53 | 45 |

| Católica de Valencia San Vicente Mártir | 62 | 54 | -8 |

| Cardenal Herrera CEU | 60 | 55 | -5 |

| Deustuko Unibersitatea (Deusto) | 15 | 56 | 41 |

| Pontificia Comillas | 45 | 57 | 12 |

| Europea de Madrid | 61 | 58 | -3 |

| Mondragón | 63 | 59 | -4 |

| Católica San Antonio de Murcia | 59 | 60 | 1 |

| Vic | 39 | 61 | 22 |

| Loyola Andalucía | 57 | 62 | 5 |

| Internacional de La Rioja | 51 | 63 | 12 |

Tabla 3 Ranking de los centros de formación superior españoles en función de los servicios que ofrecen a la comunidad científica para la consecución de la excelencia investigadora

| Institución/ Universidad | Titularidad | Input | Posición | ||||

| Acceso | Control | Coeficiente | |||||

| Repositorio | Bibliometría | Memorias e Informes | CVN | ||||

| Las Palmas de Gran Canaria | Pública | 5 | 4 | 5 | 5 | 0.95 | 1 |

| Autónoma de Barcelona | Pública | 5 | 5 | 5 | 3 | 0.9 | 2 |

| Autónoma de Madrid | Pública | 5 | 5 | 5 | 3 | 0.9 | 3 |

| Barcelona | Pública | 5 | 5 | 5 | 3 | 0.9 | 4 |

| Carlos III de Madrid | Pública | 5 | 5 | 5 | 3 | 0.9 | 5 |

| Complutense de Madrid | Pública | 5 | 5 | 5 | 3 | 0.9 | 6 |

| Granada | Pública | 5 | 5 | 5 | 3 | 0.9 | 7 |

| Oberta de Catalunya | Privada | 5 | 5 | 5 | 3 | 0.9 | 8 |

| Politécnica de Catalunya | Pública | 5 | 5 | 5 | 3 | 0.9 | 9 |

| Alcalá de Henares | Pública | 5 | 2 | 5 | 5 | 0.85 | 10 |

| Cádiz | Pública | 5 | 4 | 5 | 3 | 0.85 | 11 |

| La Laguna | Pública | 5 | 4 | 3 | 5 | 0.85 | 12 |

| Politécnica de Valencia | Pública | 5 | 4 | 5 | 3 | 0.85 | 13 |

| Alacant | Pública | 5 | 3 | 5 | 3 | 0.8 | 14 |

| Deustuko Unibertsitatea (Deusto) | Privada | 5 | 3 | 5 | 3 | 0.8 | 15 |

| Navarra | Privada | 2 | 4 | 5 | 5 | 0.8 | 16 |

| Oviedo | Pública | 4 | 3 | 4 | 5 | 0.8 | 17 |

| Politécnica de Madrid | Pública | 5 | 4 | 4 | 3 | 0.8 | 18 |

| Pompeu Fabra | Pública | 5 | 5 | 3 | 3 | 0.8 | 19 |

| Castilla-La Mancha | Pública | 5 | 2 | 5 | 3 | 0.75 | 20 |

| Murcia | Pública | 5 | 4 | 1 | 5 | 0.75 | 21 |

| Pública de Navarra | Pública | 3 | 4 | 5 | 3 | 0.75 | 22 |

| Rey Juan Carlos | Pública | 5 | 1 | 4 | 5 | 0.75 | 23 |

| Rovira i Virgili | Pública | 3 | 5 | 4 | 3 | 0.75 | 24 |

| Zaragoza | Pública | 5 | 2 | 5 | 3 | 0.75 | 25 |

| Almería | Pública | 5 | 2 | 4 | 3 | 0.7 | 26 |

| Burgos | Pública | 5 | 3 | 1 | 5 | 0.7 | 27 |

| Cantabria | Pública | 5 | 2 | 4 | 3 | 0.7 | 28 |

| Extremadura | Pública | 5 | 4 | 4 | 1 | 0.7 | 29 |

| Huelva | Pública | 5 | 1 | 5 | 3 | 0.7 | 30 |

| Illes Balears | Pública | 5 | 2 | 4 | 3 | 0.7 | 31 |

| Jaén | Pública | 5 | 1 | 5 | 3 | 0.7 | 32 |

| Jaume I | Pública | 5 | 1 | 5 | 3 | 0.7 | 33 |

| León | Pública | 5 | 3 | 1 | 5 | 0.7 | 34 |

| Nacional de Educación a Distancia | Pública | 5 | 1 | 5 | 3 | 0.7 | 35 |

| Pablo de Olavide educación | Privada | 5 | 1 | 5 | 3 | 0.7 | 36 |

| Santiago de Compostela | Pública | 5 | 3 | 5 | 1 | 0.7 | 37 |

| Sevilla | Pública | 5 | 1 | 5 | 3 | 0.7 | 38 |

| Vic | Privada | 5 | 5 | 1 | 3 | 0.7 | 39 |

| Córdoba | Pública | 5 | 1 | 4 | 3 | 0.65 | 40 |

| La Rioja | Pública | 5 | 2 | 3 | 3 | 0.65 | 41 |

| Lleida | Pública | 4 | 5 | 1 | 3 | 0.65 | 42 |

| Málaga | Pública | 4 | 1 | 5 | 3 | 0.65 | 43 |

| País Vasco | Pública | 5 | 3 | 4 | 1 | 0.65 | 44 |

| Pontificia Comillas | Privada | 5 | 1 | 4 | 3 | 0.65 | 45 |

| Ramon Llull | Privada | 1 | 5 | 4 | 3 | 0.65 | 46 |

| Valencia | Pública | 5 | 2 | 3 | 3 | 0.65 | 47 |

| Valladolid | Pública | 5 | 2 | 1 | 5 | 0.65 | 48 |

| Girona | Pública | 3 | 5 | 1 | 3 | 0.6 | 49 |

| Internacional de Catalunya | Privada | 3 | 5 | 1 | 3 | 0.6 | 50 |

| Internacional de La Rioja | Privada | 5 | 1 | 5 | 1 | 0.6 | 51 |

| Vigo | Pública | 4 | 4 | 3 | 1 | 0.6 | 52 |

| Salamanca | Pública | 5 | 2 | 1 | 3 | 0.55 | 53 |

| Miguel Hernández | Pública | 3 | 1 | 5 | 1 | 0.5 | 54 |

| San Pablo CEU | Privada | 4 | 1 | 4 | 1 | 0.5 | 55 |

| Coruña | Pública | 4 | 1 | 1 | 3 | 0.45 | 56 |

| Loyola Andalucía | Privada | 4 | 1 | 1 | 3 | 0.45 | 57 |

| Politécnica de Cartagena | Pública | 5 | 2 | 1 | 1 | 0.45 | 58 |

| Católica San Antonio de Murcia | Privada | 3 | 1 | 1 | 3 | 0.4 | 59 |

| Cardenal Herrera CEU | Privada | 4 | 1 | 1 | 1 | 0.35 | 60 |

| Europea de Madrid | Privada | 4 | 1 | 1 | 1 | 0.35 | 61 |

| Católica de Valencia San Vicente Mártir | Privada | 1 | 1 | 1 | 3 | 0.3 | 62 |

| Mondragón | Privada | 3 | 1 | 1 | 1 | 0.3 | 63 |

Clasificación de resultados

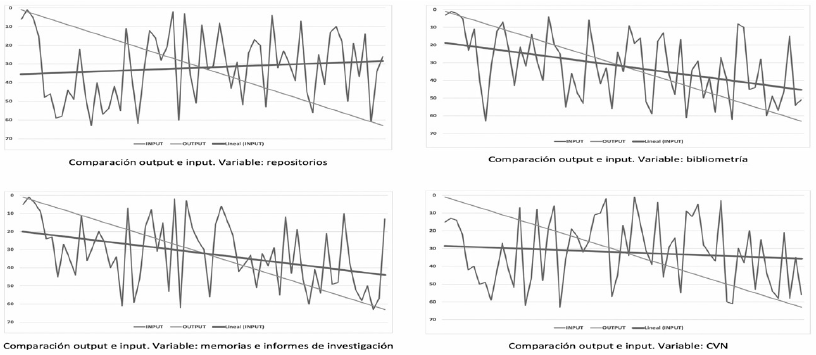

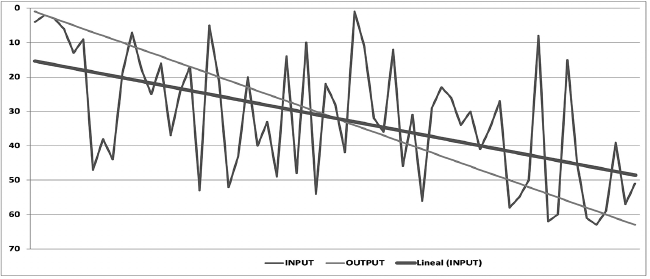

A continuación, se compara la posición inicial de las universidades según el ranking SJR (output) (abscisas) con la posición resultante de la puntuación generada al analizar las cuatro variables (input) (ordenadas). También se ofrece la línea de tendencia del análisis de los input. En este caso, la línea es negativa, lo que implica que cuanto más descienden de posición las universidades españolas, menos indicadores ofrecen para comunicar y difundir las investigaciones que realizan. Asimismo, gracias al R cuadrado o coeficiente de determinación es posible calcular la correlación entre la posición en el ranking SJR de cada universidad y la puesta en marcha de políticas para incrementar la visibilidad y comunicación de los avances científicos.

La correlación arroja un valor de -0.53 (entre moderado y fuerte), evidenciando que aquellas instituciones que mejor están situadas en el ranking SJR disponen de más y mejores herramientas para compartir el conocimiento científico (Figura 2).

Dado que las universidades se ordenan alfabéticamente en función de la puntuación obtenida, el análisis de cada variable de forma individual, aunque puede orientar la posición de la muestra analizada, no es muy significativo. Si se presentan los datos de forma conjunta, la visión es más clarificadora (Figura 3).

Conclusiones

El diagnóstico presentado permite valorar la manera en que las instituciones universitarias españolas colaboran con la excelencia investigadora.

Las puntuaciones obtenidas en los inputs han permitido ordenar a las universidades estableciendo un ranking. La correlación obtenida respecto a la posición inicial del ranking SIR (basado en el output) y la nueva ponderación demuestra que las instituciones mejor situadas disponen de más y mejores herramientas de apoyo a la investigación.

Además, se han registrado mejores posiciones para las universidades públicas que para las privadas. Las cinco primeras posiciones las ocupan centros públicos, y entre las 10 primeras sólo aparece un centro privado (Oberta de Catalunya). Parece que la manera en que se organizan los procesos de selección competitivos en el sistema de investigación incentiva la actividad investigadora, pues es un baremo relevante tanto directa (valoración de las publicaciones de impacto) como indirectamente (acreditaciones o sexenios).

Aunque los resultados evidencian cierta similitud entre los resultados del SIR y el aquí presentado, hay casos discordantes que permiten inferir que la actividad investigadora responde a iniciativas individuales y encuentra sinergias a partir del trabajo colaborativo entre diferentes instituciones, algo que encuentra justificación en el paradigma big science que, si bien suele vincularse a las ciencias y la tecnología, también encuentra cabida en las áreas de humanidades y ciencias sociales (Otroll et al., 2014).

En definitiva, se considera que los resultados obtenidos son de especial relevancia tanto para las propias instituciones -interesadas en optimizar su reputación que depende, entre otros factores, de su actividad investigadora- como para la comunidad científica que las conforma -cuya prospectiva académica se vincula a la investigación, y cuya mejora es especialmente importante para los early career researchers (Rodríguez-Bravo y Nicholas, 2019)- y redundan en la relevancia de la gestión documental y bibliotecológica para la gestión universitaria.

Aunque es necesario avanzar en esta línea de investigación, se recomienda que las instituciones trabajen políticas de colaboración con la actividad investigadora a través de departamentos especializados que fomenten la transparencia y el acceso abierto y que, a nivel interuniversitario, se establezcan patrones de actuación sistematizados que faciliten la implementación de servicios y herramientas comunes para toda la comunidad científica, independientemente de la institución a la que se adscriban de forma individual.